专为AI大模型训练和推理设计的高性能计算设备。采用国产芯片和自研散热技术,具有高能效比、高可靠性和易扩展等特点。

采用最新国产AI芯片,提供强大的计算能力,支持大规模模型训练和高效推理,满足企业AI应用需求。

创新散热设计和电源管理技术,大幅降低能耗,相比传统服务器节能30%以上,降低运营成本。

采用国产化核心部件,确保数据和技术安全,满足关键行业对自主可控的严格要求。

模块化设计,支持按需扩容,轻松应对业务增长需求,保护企业技术投资,降低总体拥有成本。

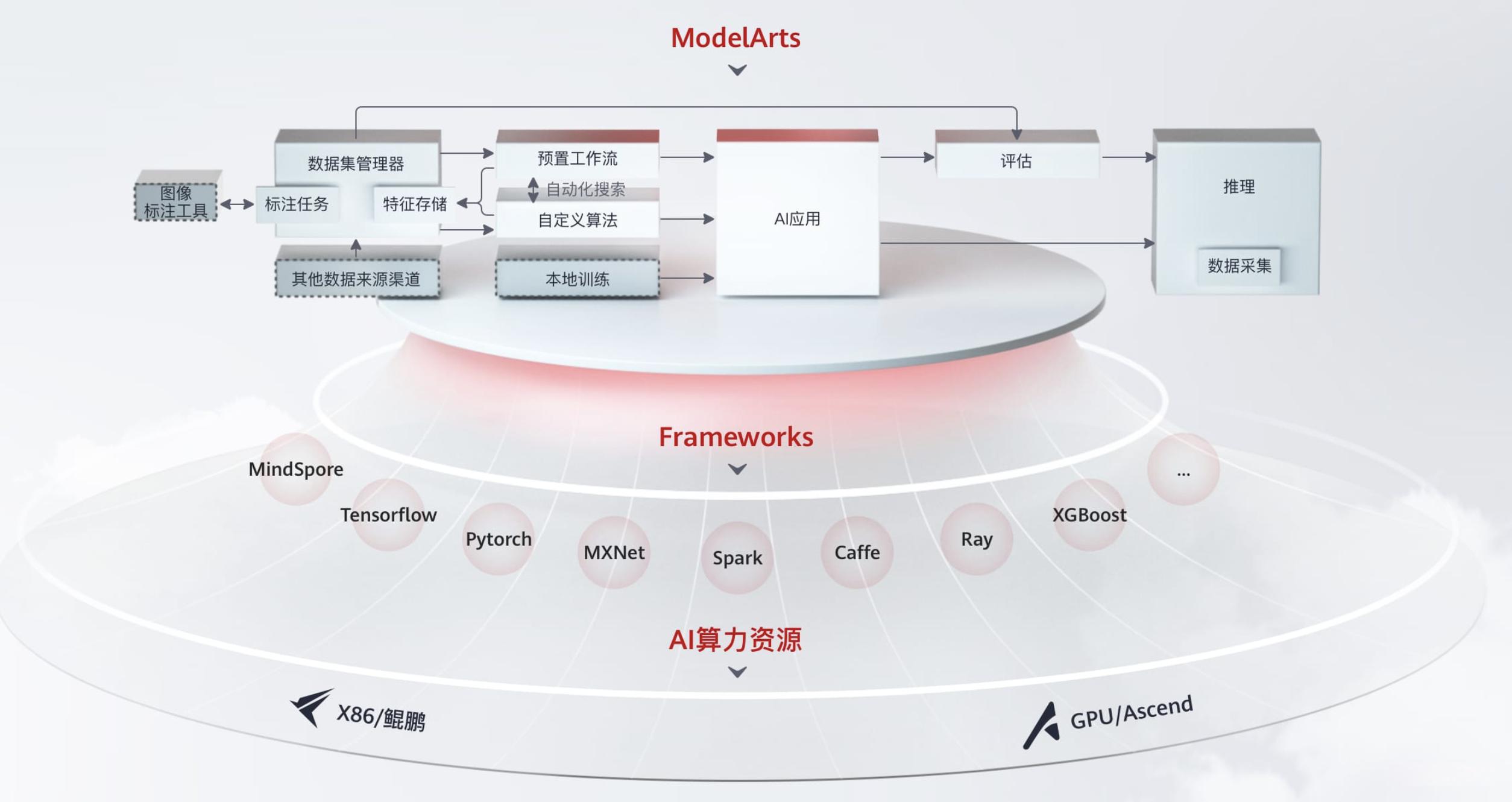

我们的国产化大模型服务器采用先进的多层次架构设计,整合了高性能计算单元与灵活的存储解决方案,为大模型训练与推理提供强大底层支持。服务器架构包含:

与同类产品相比,我们的国产化大模型服务器在以下关键性能指标上表现卓越:

某国家级研究院在大规模语言模型研发中采用我们的国产化大模型服务器,成功实现:

该项目成为国家级AI基础设施建设的标杆案例,为国产化AI计算设备树立了新标准。

| 规格项 | 参数 |

|---|---|

| 处理器 | 国产AI芯片,最高支持8颗 |

| 内存 | 最大支持2TB DDR5 |

| 存储 | 最大支持24个NVMe SSD |

| 网络接口 | 4×100GbE QSFP28 |

| 电源 | 2000W 1+1冗余 |

| 散热 | 自研液冷散热技术 |

| 操作系统 | 支持主流国产操作系统 |

| 尺寸 | 4U机架式 |

该研究院需要建设大规模AI计算集群,用于国家重点科研项目的大模型训练和推理。通过部署云智银河国产化大模型服务器,构建了完全自主可控的高性能计算平台。

平台上线后,模型训练速度提升40%,能耗降低35%,系统稳定性显著提升,为科研项目提供了强有力的算力支持,加速了多项国家级科研成果的产出。